W branży technologicznej, gdzie od lat panuje mantra „im większe, tym lepsze”, Google postanowiło pójść pod prąd. Zamiast kolejnego cyfrowego potwora o apetycie na całą energię z pobliskiej elektrowni, firma zaprezentowała coś zupełnie odwrotnego – model AI o nazwie Gemma 3 270M. Liczba w nazwie jest tu kluczowa, ponieważ zdradza jego rozmiar – zaledwie 270 milionów parametrów. Jeśli to nic Ci nie mówi, spieszę z wyjaśnieniem… to kruszynka w porównaniu do gigantów, których parametry liczy się w miliardach, a nawet bilionach. Google twierdzi, że w tym szaleństwie jest metoda, a ich mały model potrafi zawstydzić znacznie większych konkurentów. Czyżby nadchodziła era liliputów w dziedzinie sztucznej inteligencji?

Mała Gemma – co to takiego?

Nowy członek rodziny modeli Gemma, oznaczony jako 270M, został zaprojektowany od podstaw z myślą o jednym – wydajności i specjalizacji. W odróżnieniu od swoich większych kuzynów, którzy próbują być ekspertami od wszystkiego, od pisania poezji po analizę rynków finansowych, Gemma 3 270M ma być jak precyzyjne narzędzie w rękach rzemieślnika. Zamiast młota kowalskiego dostajesz skalpel chirurga. Google jasno komunikuje – nie próbujcie z nim prowadzić głębokich, filozoficznych dyskusji o sensie życia. Ten model ma wykonywać konkretne, dobrze zdefiniowane zadania i robić to szybko, tanio i bez zużywania baterii w telefonie w pięć minut.

Jego architektura składa się z 270 milionów parametrów, z czego 170 milionów to parametry osadzania (odpowiadające za rozumienie słów), a pozostałe 100 milionów to bloki transformatorowe, czyli właściwy „mózg” operacji. Co ciekawe, model dysponuje ogromnym jak na swój rozmiar słownikiem, zawierającym 256 tysięcy tokenów. Daje mu to zdolność do rozumienia i przetwarzania rzadkich lub bardzo specyficznych słów, a to czyni go świetną bazą do dalszego trenowania w niszowych dziedzinach, na przykład w medycynie czy prawie.

Efektywność energetyczna – czyli dlaczego twoja bateria go pokocha

Jedną z cech nowej Gemmy, która robi szczególne wrażenie, jest jej apetyt na energię, a właściwie jego brak. W dzisiejszych czasach, gdy nasze smartfony ledwo wytrzymują dzień na jednym ładowaniu, każda aplikacja działająca w tle to potencjalny wróg. Google przeprowadziło wewnętrzne testy na telefonie Pixel 9 Pro. Wyniki? Model w wersji zoptymalizowanej (INT4-quantized) zużył zaledwie 0,75% baterii do przeprowadzenia 25 rozmów. Taki wynik sprawia, że Gemma 3 270M jest najbardziej energooszczędnym modelem w całej rodzinie Gemma.

Co to oznacza w praktyce? Otwiera to drzwi do tworzenia aplikacji, które wykorzystują zaawansowane AI działające w pełni na Twoim urządzeniu, bez konieczności wysyłania danych do chmury. Przetwarzanie na urządzeniu to nie tylko oszczędność baterii, ale także ogromny skok w dziedzinie prywatności i szybkości działania. Twoje dane nie muszą opuszczać telefonu, aby aplikacja mogła dokonać analizy sentymentu w mailach, streścić artykuł czy inteligentnie posegregować notatki. Wszystko dzieje się lokalnie, co jest szybsze i bezpieczniejsze.

Filozofia właściwego narzędzia do właściwej pracy

Google w materiałach promocyjnych zręcznie unika określania Gemmy 3 270M jako konkurenta dla wielkich modeli. Zamiast tego, promuje filozofię, którą każdy dobry inżynier zna na pamięć – do powieszenia obrazu nie używa się młota wyburzeniowego. Tak samo w AI, używanie ogromnego, kosztownego modelu do prostego zadania, jak klasyfikacja tekstu, jest zwyczajnym marnotrawstwem zasobów.

Prawdziwa siła małej Gemmy ma objawić się po procesie tzw. “fine-tuningu”, czyli dostosowywania jej do konkretnego zadania. Google udostępnia model bazowy, który już na starcie nieźle radzi sobie z podążaniem za instrukcjami. Dopiero gdy deweloperzy wezmą go na warsztat i „nauczą” go swojej specjalizacji, model pokaże pazury. Może stać się ekspertem od wykrywania spamu, mistrzem w analizie opinii klientów albo błyskawicznym narzędziem do wyciągania konkretnych danych z tysięcy dokumentów. A wszystko to przy drastycznie niższych kosztach utrzymania i wnioskowania (inferencji) w porównaniu do rozwiązań chmurowych opartych na wielkich modelach.

Sukces takiego podejścia już został udowodniony w praktyce. Firma Adaptive ML, we współpracy z SK Telecom, stanęła przed wyzwaniem moderacji treści w wielu językach. Zamiast sięgać po największe dostępne na rynku modele, zdecydowali się na fine-tuning większego modelu z tej samej rodziny – Gemma 3 4B. Efekty przerosły oczekiwania – wyspecjalizowany model nie tylko dorównał, ale wręcz przewyższył wydajnością znacznie większe, komercyjne modele w swoim konkretnym zadaniu. Gemma 3 270M ma pozwolić deweloperom pójść o krok dalej i osiągnąć jeszcze większą wydajność w precyzyjnie zdefiniowanych zadaniach.

Kiedy mała Gemma jest najlepszym wyborem?

Twórcy modelu jasno określają scenariusze, w których ich nowe dziecko sprawdzi się najlepiej. Jeśli jesteś deweloperem lub po prostu interesujesz się, gdzie technologia ta znajdzie zastosowanie, oto kilka wskazówek prosto od Google.

- Masz do wykonania zadanie o dużej skali, które jest jednocześnie dobrze zdefiniowane. Przykładami mogą być analiza sentymentu (czy opinia jest pozytywna, czy negatywna), wyciąganie encji (np. wyszukiwanie nazwisk i miejsc w tekście), inteligentne kierowanie zapytań do odpowiednich działów w firmie czy przekształcanie nieustrukturyzowanego tekstu w uporządkowane dane.

- Liczysz każdy grosz i każdą milisekundę. Dostosowany model 270M może działać na bardzo taniej infrastrukturze lub bezpośrednio na urządzeniach użytkowników. Eliminuje to lub znacząco obniża koszty związane z korzystaniem z API zewnętrznych modeli i jednocześnie przyspiesza działanie aplikacji.

- Musisz szybko eksperymentować i wdrażać nowe rozwiązania. Niewielki rozmiar Gemmy 3 270M pozwala na błyskawiczne cykle fine-tuningu. Testowanie różnych konfiguracji i znalezienie optymalnego rozwiązania dla danego problemu zajmuje godziny, a nie dni.

- Prywatność użytkowników jest dla Ciebie priorytetem. Dzięki możliwości uruchomienia modelu w całości na urządzeniu końcowym, możesz tworzyć aplikacje, które przetwarzają wrażliwe dane bez wysyłania ich gdziekolwiek. To ogromna zaleta w czasach, gdy troska o prywatność staje się coraz ważniejsza.

- Chcesz zbudować całą flotę wyspecjalizowanych modeli. Zamiast jednego molocha, który próbuje robić wszystko, możesz stworzyć wiele małych, wyspecjalizowanych ekspertów, z których każdy jest mistrzem w swojej wąskiej dziedzinie. Taki system może być znacznie bardziej wydajny i tańszy w utrzymaniu.

Dlaczego to ma sens?

Cała rodzina modeli Gemma od Google cieszy się rosnącą popularnością, co potwierdza liczba pobrań, która niedawno przekroczyła 200 milionów. Tak ogromny wynik pokazuje, że istnieje zapotrzebowanie na otwarte, dostępne i wydajne modele, z którymi deweloperzy mogą swobodnie eksperymentować. Rynek zdaje się doceniać alternatywę dla zamkniętych, kosztownych systemów. Wprowadzenie tak małego i wyspecjalizowanego modelu jak Gemma 3 270M jest logicznym krokiem w tej strategii – zaspokaja potrzeby tych, którzy nie potrzebują wszechstronności największych graczy, ale za to cenią sobie szybkość, niski koszt i kontrolę nad procesem.

Jak zacząć przygodę z małą Gemmą?

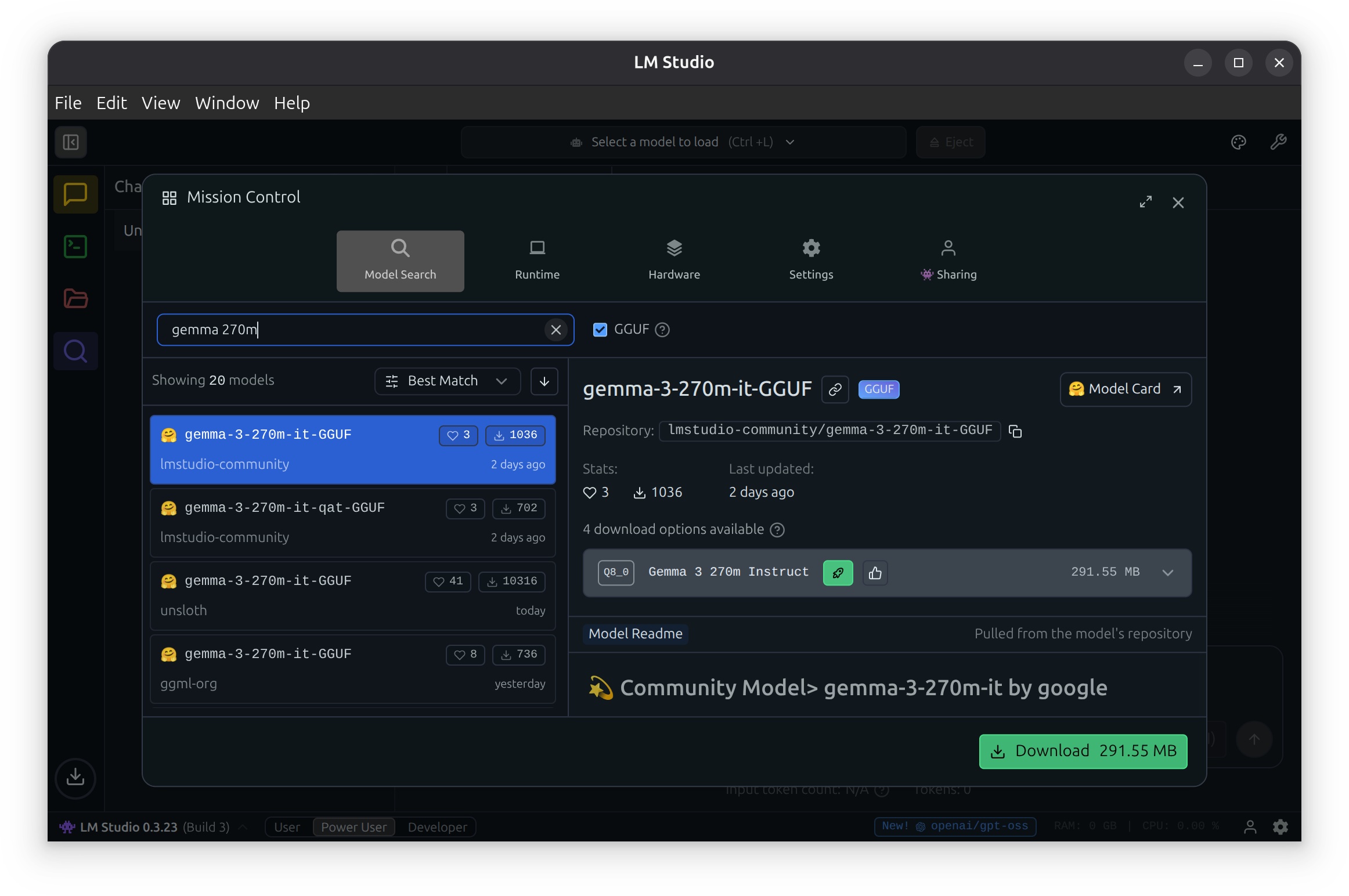

Google postarało się, aby próg wejścia był jak najniższy. Model jest dostępny do pobrania na popularnych platformach, takich jak Hugging Face, Ollama, Kaggle czy Docker. Dostępne są zarówno wersje wstępnie wytrenowane (pre-trained), jak i te już dostosowane do wykonywania instrukcji (instruction-tuned). Dla tych, którzy potrzebują maksymalnej wydajności na urządzeniach o ograniczonych zasobach, przygotowano specjalne wersje QAT (Quantization-Aware Trained), które pozwalają na pracę z obniżoną precyzją bez znaczącej utraty jakości.

Do samego procesu fine-tuningu można używać popularnych narzędzi, takich jak Hugging Face, UnSloth czy JAX. Po dostosowaniu gotowy model można wdrożyć praktycznie wszędzie – od lokalnego serwera, przez chmurę Google Cloud Run, aż po aplikację na smartfonie.

Mały krok dla modelu, wielki skok dla deweloperów

Premiera Gemmy 3 270M może nie wywołała medialnej burzy na miarę prezentacji GPT-5, jednak w środowisku deweloperów i inżynierów AI jest to wiadomość niezwykle istotna. Jest to sygnał, że branża dojrzewa i zaczyna rozumieć, że nie zawsze potrzebujemy armaty do zabicia komara. Era wszechmocnych, monolitycznych modeli AI powoli ustępuje miejsca erze specjalizacji, efektywności i decentralizacji.

Gemma 3 270M to zgrabne, przemyślane narzędzie, które w odpowiednich rękach może przynieść ogromne korzyści. To także ukłon w stronę społeczności open-source i dowód na to, że innowacje w AI mogą mieć różne kształty i rozmiary. Zamiast więc z zachwytem patrzeć tylko na największe i najgłośniejsze modele, warto czasem spojrzeć w dół, bo tam, w skali mikro, dzieje się prawdziwa rewolucja. I, co najważniejsze, nie pożre ona Twojej baterii w drodze do pracy.

Źródła: Google for Developers, Własne